Comment a-t-on commencé à s’abrutir. Pourquoi l’abondance du savoir n’incite pas à apprendre?

Tout ce que l’homme ignore n’existe pas pour lui. Donc l’univers de chacun se résume à la taille de ses connaissances.

Albert Einstein

- Pourquoi il y a une baisse de culture générale?

- Pourquoi à l’époque où l’accès aux connaissances innombrables est plus facile que jamais, l’Homme en semble être désintéressé comme jamais?

- Pourquoi l’apparition des technologies (permettant d’apprendre plus et mieux à tout le monde) semble, à rebours, légumiser le plus grand nombre?

Voici un raisonnement fondé sur mes observations, mes lectures et des débats pluriannuels avec des jeunes en BAC+4/5 et des adultes (bien plus âgés), tous horizons et classes sociales.

Accumulation du savoir

Il y a 300.000 ans

Depuis les découvertes fossiles les plus anciennes à Jebel Irhoud au Maroc en 1960, on considère que l’Homo sapiens, l’humain moderne, arpente cette terre depuis 300.000 ans. Mais l’écriture, elle, n’existe que depuis 5.000 ans.

De manière très simpliste, pendant 295.000 ans le savoir se transmettait à l’oral. Or l’accumulation du savoir était impossible pour des raisons évidentes. Dans le contexte du nomadisme et des conditions de vie (dans lesquelles on n’est même pas capables de se projeter aujourd’hui) la mémoire des ancêtres, avec leurs pratiques de survie et les croyances liminaires, se transmettaient par des chants et des rituels répétitifs. En plus, l’espérance de vie assez courte n’aidait pas non plus au développement rapide du savoir. Ce qui fait que l’organisation sociale de l’homme restait assez primitive.

Il y a 5.000 ans

Et il y a 5.000 ans, le savoir a commencé à s’accumuler très progressivement. Or, toujours de manière aussi simple et grossière: à mi-chemin, il y a 2.500 ans dans la Grèce Antique, Socrate (470-469 av. J.-C.) aurait dit: “Le premier savoir est le savoir de mon ignorance” (“Je ne sais qu’une chose, c’est que je ne sais rien“). Sous-entendant que le savoir était déjà trop vaste et inaccessible dans son entièreté même aux érudits.

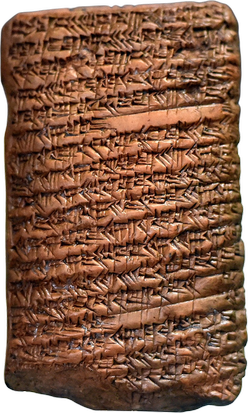

Au bout de 2.500 ans de transmission du savoir par écrit, ni la capacité du cerveau humain, ni la durée d’une vie humaine ne permettaient plus à appréhender la totalité des connaissances apparues. Même si les techniques d’écriture à la fin du Néolithique (il y a ~5.000 ans), en passant par l’Âge du cuivre et du bronze (il y a ~4.500 ans), tout droit vers l’Antiquité (il y a ~3.000 ans) ne ressemblaient pas vraiment au stylo BIC sur du papier tout blanc et lisse. Sans parler du fait que les alphabétisés de chaque royaume pouvaient certainement se compter sur les doigts des deux mains. Et le prix des livres, même déjà au premier millénaire de notre ère, restait exclusivement dans la catégorie du clergé et des nobles.

Transmission chaotique du début

Il y a 2.500 – 3.770 ans

Par exemple, cette tablette d’argile babylonienne a révélé que le théorème de Pythagore était en réalité connu plus de 1.200 ans avant le mathématicien grec (580-495 av. J.-C.). Datant de 1.770 av. J.-C., cette tablette contient des calculs utilisant le célèbre théorème pour déterminer la diagonale d’un rectangle. Une autre tablette, datant d’environ 1800 à 1600 av. J.-C., confirme que les Babyloniens non seulement connaissaient ce principe mathématique, mais comprenaient également les nombres irrationnels, comme en témoignent leurs calculs impliquant la racine carrée de deux.

Les historiens suggèrent que l’école fondée par Pythagore dans la Grèce antique a largement contribué à populariser et à diffuser la connaissance de ce théorème, même si elle n’en est probablement pas à l’origine. Comme aucun écrit de Pythagore lui-même n’a survécu, une grande partie de ce qui lui est attribué a été transmise oralement et créditée à son nom par respect. Même s’il n’a peut-être pas été le premier à découvrir ce théorème, son influence a permis de l’ancrer au cœur des mathématiques pour des millénaires.

Et, d’ailleurs, l’histoire est bourrée d’exemples de ce genre, lorsque celui dont le nom est connu de tous n’est qu’une trompette parlante (influenceur, dirait-on aujourd’hui) de la découverte ou de l’innovation.

Débuts de l’exponentielle

Il y a 1200 – 400 ans

Au 2ème siècle de notre ère, les Chinois ont inventé le papier, dont ils gardaient précieusement le secret pendant plusieurs centenaires, mais qui a fini par fuiter sur la route de la soie. Et l’apparition du papier au Moyen-Orient avant l’imprimerie a provoqué une croissance de vie intellectuelle. Les 500 ans ayant suivi le début de la production du papier au 8e siècle à Samarkand (grand centre du savoir) sont connus comme l’âge d’or de l’Islam. Bien qu’il soit évident que ce grand centre du savoir n’avait pas touché la totalité des populations de l’époque dans la région.

Ulugh Beg, le souverain de Samarkand au 15e siècle, ayant construit 3 universités, est aujourd’hui connu comme un astronome qui a, aussi, construit un observatoire 200 ans avant que Galilée n’invente le télescope. Ulugh Beg a calculé une année solaire avec une précision qui, aujourd’hui, est rectifiée par l’IA de seulement 1 minute et 2 secondes.

On estime jusqu’à 400 papeteries au moyen âge autour de Samarkand, pendant que l’Europe traversait sa période sombre. Ensuite, la science islamique et le papier, sur lequel elle était publiée, ont fini par trouver leur chemin vers l’Europe et contribuer d’ajouter les bases d’une révolution scientifique.

Il y a 600 ans

En 1448, l’invention de l’impression par Gutenberg (Johannes Gensfleisch de son vrai nom, à Mayence en Allemagne) a accéléré et facilité la diffusion des savoirs. S’en est suivi (très) progressivement l’alphabétisation généralisée en Europe, ouvrant ainsi la parenthèse de Gutenberg (je l’expliquerai plus tard).

De cette manière, dans la très récente période de l’histoire humaine, l’accumulation et la diffusion du savoir a littéralement explosé. Il est devenu possible de produire en deux semaines un livre entier en 1250 exemplaires. Tandis qu’auparavant, un scribe ne produisait qu’un livre par an. Il en va de soi, le prix des livres est parti à la baisse. Ce qui fait de l’imprimerie une des plus influentes inventions de l’histoire.

Il y a moins de 100 ans

Et depuis moins d’un siècle, avec la numérisation, nous assistons à une accumulation exponentielle du savoir et des informations, dont le volume dépasse l’entendement. On peut même parler de l’accumulation infinie des données, à l’instar de l’accumulation infinie du capital, dont je traite l’absurdité dans mon livre Psychologie des (nouveaux) riches. Notions bien différentes, mais leur aspect d’accumulation infinie coïncide à la même époque — la nôtre.

Il semblerait que l’accumulation des données devrait plutôt être positive. Seulement, il est central — surtout à notre époque — de distinguer clairement 2 rudiments:

- le savoir et

- les informations (ou les données).

Le savoir étant quelque chose de constructif, d’utile et de cohésif. Les informations (ou les données) c’est le brouhaha général, qui va et qui vient; remplacé d’un jour à l’autre par la nouvelle cacophonie — désormais incessante — de “news” et de “données”, telles les vagues de l’océan. Je ne vais même pas entrer dans le raisonnement sur l’utilité de ces données, toutes idioties confondues publiées sur les réseaux sociaux et consorts, dans un seul et unique but des “créateurs” — exister aux yeux des 8 Mrds de leurs semblables.

Internet a donné une seconde vie à la stupidité: autrefois elle tombait dans l’oubli, désormais elle est archivée.

Umberto Eco

Déjà en 2018, on estimait que 90 % des données disponibles dans le monde ont été créées dans les deux années précédentes (2016-2017). Je serais tenté de dire “imaginez où nous en sommes presque 10 ans plus tard”. Mais en réalité, il est impossible de l’imaginer. Car aujourd’hui, il est estimé que l’humanité produit 29.000 Giga-octets de données PAR SECONDE. Cette quantité, et à la fois cette densité de données en si peu de temps, n’est même plus concevable pour le cerveau humain. Au point que ce volume de “BIG data” donne naissance à de nouveaux types de statistiques. En revanche, je vous laisse imaginer la faible proportion du savoir réellement utile dans tout ce ramassis de données — si voluptueusement encensé par les grands prêtres du numérique et de l’IA, secondés par leurs fidèles idiots utiles.

Mais il n’empêche que sur le fond de la bêtise du quidam, ainsi que de la propagande en tout genre publiées continuellement un peu partout le monde — fort heureusement, l’accumulation du vrai savoir (de plus en plus complexe) se poursuit.

Culture générale

Néanmoins, dans le contexte de cette conclusion, en voici le corollaire et la raison d’être de ce papier. L’aspiration humaine à l’autodéveloppement et à l’autoamélioration semble être inversement proportionnelle à la facilité d’apprentissage et à l’arborescence croissante du savoir utile. Je vous mets les choses en perspective.

La facilité d’accès aux connaissances jamais vue dans l’histoire et les méthodes d’apprentissages aussi ludiques qu’elles étaient rébarbatives il y a 100-200 ans, le niveau et la qualité des savoirs interdisciplinaires immenses accumulés de nos jours devraient clairement assoiffer le plus grand nombre et pousser à nourrir continuellement le cerveau de l’homo sapiens — réfléchi, collaboratif, innovant et curieux.

Mais l’intelligence artificielle (apparemment censée penser à notre place) et l’outsourcing du savoir (l’externalisation des connaissances sur des serveurs distants) créent un paradoxe: l’homo sapiens semble avoir tendance à ne plus rien vouloir apprendre, sous prétexte que toutes ces connaissances sont à la portée d’un clic.

Dans le temps, les gens n’avaient pas la possibilité, la méthode et les moyens d’apprendre. Donc il est presque normal que la majorité demeurait analphabète et ignorante. Mais aujourd’hui…

Derrière la façade vertueuse que tout le monde de nos jours n’arrête pas d’apprendre, notamment dans les écoles, la réalité est que la culture générale de la masse générale baisse d’une année à l’autre. Car le fait de trouver épisodiquement les réponses aux questions auprès du chat GPT n’améliore en rien les connaissances, ni les neurones, ni la mémoire.

Tout ce que l’homme ignore n’existe pas pour lui. Donc l’univers de chacun se résume à la taille de ses connaissances.

Albert Einstein

Paradoxe de Jevons

Et alors, qu’est-ce qu’on a aujourd’hui? Question qui tue…

L’humanité semble à nouveau mettre en évidence l’effet de rebond, mais cette fois de façon différente. Ce paradoxe a été démontré en 1865 par l’économiste et logicien britannique William Stanley Jevons:

à mesure que les améliorations technologiques augmentent l’efficacité, avec laquelle une ressource est employée, la consommation totale de cette ressource peut augmenter au lieu de diminuer. En particulier, ce paradoxe implique que l’introduction de technologies plus efficaces en matière d’énergie peut, dans l’agrégat, augmenter la consommation totale de l’énergie.

En plus simple: une augmentation de la consommation qui dépasse les gains d’efficacité. C’est le serpent qui se mord la queue.

Et maintenant, 2 observations basées sur l’effet de rebond.

- Premièrement, les données à l’économie numérique sont ce que les combustibles fossiles à l’alimentation en énergie. Plus on en consomme et plus on en a besoin / envie. C’est une véritable addiction des junkies. Corollaire: les IA sont censées traiter les masses colossales de données produites par 8 milliards d’humains, qui ne sont pas capables de les brasser eux-mêmes. Or ces mêmes IA créent à leur tour des données en progression géométrique au point qu’on pourrait s’amuser à envisager le moment X, où les IA elles-mêmes deviendraient débordées par le Big Data en surproduction — le dada du progressisme et du modèle économique actuels.

- Et deuxièmement. L’Homme semble fonctionner selon le principe inverse à l’effet de rebond: diminution de sa culture générale (consommation du savoir utile) est à l’extrémité opposée de l’accumulation continue de ce même savoir.

Sans oublier que l’accumulation du savoir utile, comme d’habitude, n’est possible que grâce à une maigre couche de population, comparée à la masse des homo sapiens continuant à arpenter cette planète.

L’effet de Wikipédia:

savoir où trouver l’information a remplacé le fait de savoir. Une espèce de sabotage de la neuroplasticité à cause de la “suralimentation algorithmique à la petite cuillère”.

La théorie de l’effondrement de “La parenthèse de Gutenberg” (par Jeff Jarvis) suggère que l’ère de l’imprimerie (1450–2000) était une anomalie historique — une parenthèse caractérisée par:

- la pensée linéaire (les livres comme récits séquentiels),

- le culte de l’auteur (texte fixe et créativité individuelle),

- la lecture attentive et réfléchie (analyse, pas simple survol).

Avec la numérisation, nous sortons de ces parenthèses, revenant à un monde pré-Gutenberg de:

- savoir fragmenté (TikTok/Instagram contre livres),

- culture orale 2.0 (mèmes, discours viraux),

- dématérialisation du texte (les hyperliens détruisent la “sacralité” du livre),

- érosion de l’autorité (algorithmes = experts).

Pourquoi est-ce important? Internet n’a pas seulement changé les médias — il a défait les habitudes cognitives construites par l’imprimerie en 500 ans. Aujourd’hui, nous sommes dans l’ère de post-alphabétisation, mais pas plus sages pour autant.

Question: construisons-nous des bibliothèques ou des béquilles?

Voici le paradoxe de l’ère numérique: alors qu’Internet démocratise le savoir, il immortalise aussi l’ignorance. Contrairement aux époques pré-numériques, où les idées insensées disparaissaient souvent faute de portée, l’idiotie d’aujourd’hui est algorithmiquement ressuscitée et amplifiée. Corollaire: la désinformation éternelle avec de l’engrais algorithmique. Les plateformes récompensent l’engagement, pas la vérité, rendant la stupidité plus contagieuse que la sagesse. L’ironie de l’histoire: l’outil destiné à nous éclairer catalyse en parallèle nos (nombreux) biais cognitifs.

Nous sombrons littéralement dans le paradoxe du déclin mental à l’ère de l’abondance des connaissances:

- L’illusion de la sagesse — Google et l’IA fournissent des réponses, mais privent de l’effort forgeant une véritable compréhension (effondrement de la parenthèse de Gutenberg).

- L’attention, ressource en voie de disparition — désormais notre cerveau se concentre sur la reconnaissance de l’information plutôt que son traitement.

- Dépendance aux cyborgs — déléguer la connaissance à un simple clic atrophie notre mémoire comme celle d’un poisson rouge.

Délibération

Il est évident qu’à toutes les époques la majorité de la population ne cherchait pas à s’instruire et à s’améliorer, autant que la majorité écrasante d’aujourd’hui passe son temps libre à consommer du contenu dépossédé de quelconque sens peu ou prou intelligible. En d’autres termes, le contenu de merde.

Mais pourquoi sommes-nous comme ça? Peut-être, parce que de nos jours le savoir utile est trop pollué par l’inutile? Ça veut dire qu’on est exposé davantage à des données de merde plutôt qu’au savoir utile? Ou peut-être parce qu’on ne sait pas faire la distinction entre les uns et les autres? Ou parce que les données de merde (inutiles) sont plus faciles et alléchantes?

Est-ce possible d’inverser la tendance? Qui n’est, d’ailleurs, plus vraiment une tendance, mais plutôt un fait avéré et bien invétéré. Ou l’humanité est déjà perdue, s’abandonnant avec abnégation et insouciance sur une pente glissante, où une majorité satisfaite (qui, soit dit en passant, ne lira jamais cet article) s’adonne aux émotions extatiques grâce à des technologies qui pourraient favoriser son autodéveloppement — par là même, en diminuant la médiocratie ambiante?

Peut-on encore inspirer la jeunesse d’aujourd’hui à apprendre pour comprendre les ambiguïtés et la complexité du monde qui l’entoure, au lieu de vouloir devenir influenceurs se prenant en photo dans un jet privé loués pour 20 min, le temps d’une parade pour mettre de la poudre aux yeux sur Instagram et TikTok? Et puis, pourquoi leurs aînés, considérant que c’était mieux avant et que les jeunes sont une catastrophe, consomment autant de contenu de merde et délaissent le vrai savoir de côté?

Bon, il faut dire aussi que la quantité du savoir utile (pas de données) est aujourd’hui tellement démesurée par rapport à la capacité d’apprentissage et de la mémoire biologique, dont l’humain est doté, que non seulement son apprentissage en entier n’est pas envisageable mais, en plus, sa croissance incessante est du genre à faire baisser les bras aux plus curieux et prodiges que l’espèce puisse procréer.

Alors, il est possible qu’en conscience de ce constat (tout en restant inconsciente de son énorme indolence et nonchalance), la “masse” ne cherche plus à s’instruire continuellement — à “devenir chaque jour une meilleure version de soi-même”, comme dirait l’autre. D’autant plus que, apparemment, l’IA est maintenant là pour tout faire à notre place…

Et qui plus est, la soif de savoir naît souvent du désir (besoin) de tout contrôler et comprendre immédiatement. Alors que la véritable connaissance exige de la patience (donc du temps et de la persévérance), du doute et l’acceptation de ne pas savoir (coucou Socrate).

C’est peut-être pour cette raison que certains veulent mettre au point des micro chips intégrés directement au cerveau. Après tout, c’est peut-être le seul moyen de tirer la masse vers le haut? Le développement de l’être humain en tant qu’individu grâce au cybersavoir (d’une réalité augmentée cybernétique)?

Seulement quel genre de savoir? Lorsqu’on sait que le préfixe cyber provient du grec ancien kubernao qui signifiait “diriger un navire” et kubernēsis, “don de gouvernance”. Et qu’aujourd’hui, on définit la gouvernance comme faire passer un système d’un état à un autre à travers des actions ciblées du gouvernant (en respectant certains critères d’optimisation)…

Nicholas Scarpinato

Nicholas Scarpinato

© Marcel Caram

© Marcel Caram

Réflexion très intéressante… J’avais lu chez Bernard Stiegler (philosophe qui était très préoccupé par le savoir, il a écrit, entre autres, La télécratie contre la démocratie) que la technologie se substitue peu à peu (et aujourd’hui plus rapidement, vu l’accélération du progrès technologique) à nos capacités naturelles, comme la mémoire, par exemple.

À l’époque des sociétés orales, un contemporain de Socrate (de sa caste !) pouvait aisément réciter, sans effort, l’équivalent d’un livre de 200 pages. Par ailleurs, Socrate lui-même émettait certaines réserves sur la science écrite: il considérait que cela provoquerait fatalement le déplacement du savoir, passant du cerveau aux écrits (et il n’avait pas tout à fait tort). L’écrit était également considéré par les philosophes de la Grèce antique comme un Pharmakon, c’est-à-dire un remède pouvant aussi se révéler être un poison ! (En effet, on peut écrire Les Misérables, mais également Mein Kampf…)

Plus récemment, sur la même réflexion, des philosophes tels que Simondon expliquent que la véritable prolétarisation des individus est un processus qui consiste à transférer le savoir (et/ou leur savoir-faire) de ces derniers à la machine. Par conséquent, un prolétaire est, en définitive, celui à qui l’on a confisqué son savoir et/ou son savoir-faire, par des dispositifs techniques, voire technologiques, à l’intérieur d’un paradigme (le fameux Progrès !) qu’il aurait lui-même fondé. Le paradigme économique basé sur le profit illimité est une cause directe de ce phénomène…

Bref, nous sommes bien loin du vœu pieux des Lumières qui souhaitaient la généralisation de l’individualisme (à ne pas confondre avec l’égoïsme), c’est-à-dire permettre aux individus de penser par eux-mêmes ! La saturation de l’information produite par la technologie actuelle met définitivement à mal ce projet, au point de créer des individus qui ne désirent plus rien, puisque l’abondance neutralise fatalement le désir. De plus, une économie fondée sur l’excès d’image suscite la pulsion et donc l’imitation, et non plus la pensée…

Précision:

Quel phénomène? Le progrès? La dépossession du prolétaire de son savoir par la technologie?

Et puis:

Donc c’est la fin des temps? Ou est-ce simplement une phase historique amenant vers quelque chose d’autre (comme l’écriture, l’impression, la machine à vapeur en leur temps)?